Surveillance de masse, terrorisme et statistiques

Posté le Wed 03 April 2019 dans Réflexions

Temps de lecture estimé : 10 minute(s).

La surveillance de masse est un sujet toujours plus d'actualité. Il y a bien sûr les grosses entreprises du net, avec en tête Google, Amazon et Facebook, qui veulent récolter un maximum d'informations sur nous afin de nous proposer toujours plus de publicité ciblée. Et il y a aussi les états, qui veulent pouvoir contrôler le comportement de leurs citoyens, pour diverses raisons plus ou moins avouables et justifiées.

Je vais laisser la publicité de côté et essayer ici de réfléchir un peu sur le second point.

La menace terroriste

La raison la plus souvent mise en avant pour justifier l'intensification de la surveillance au sein d'un pays est la menace terroriste. Après un événement malheureux comme celui-ci, il y a toujours une période de flottement où tout le monde se demande ce qu'on pourrait faire pour éviter que cela se reproduise. Et commencent alors les débats entre deux clans : celui qui veut plus surveiller pour mieux prévenir, quitte à perdre un peu de leur vie privée, et celui qui refuse d'être encore plus surveillé et qui argue que la surveillance de masse n'apportera aucune sécurité supplémentaire.

Après un attentat, le syndrome du grand méchant monde est encore plus amplifié que d'habitude, et nous sommes alors plus enclins à accepter des règles de surveillance plus strictes. Et puis, après tout, cela parait logique : si on surveillait plus les citoyens, on devrait identifier plus de personnes radicalisées, on devrait repérer plus de réseaux terroristes, et on devrait mettre plus de méchants derrière les barreaux. Et ça, c'est plutôt bien pour le peuple, non ?

Le débat classique autour de la vie privée

La défense des libertés individuelles...

L'argument des personnes qui sont contre cette surveillance de masse est souvent celui de la diminution des libertés individuelles, et de la défense de la vie privée. Argument avec lequel je suis plutôt d'accord. (Eh oui, je fais plutôt partie du second clan...)

Puis-je accepter que mes données soient récoltées, stockées, analysées, puis étudiées à des fins statistiques ? Non, et peu importe la raison. Je n'ai pas envie que quelqu'un, ou quelque-chose, puisse me suivre à la trace, analyser le contenu des mes emails, de mon historique internet, analyser mon activité sur les réseaux sociaux, en déduire mon profil religieux, mon profil politique, mon niveau de vie, mes préférences sexuelles ou je ne sais quoi d'autre.

... et le fameux "Je n'ai rien à cacher"

Seulement, il y a le bien connu "je n'ai rien à cacher". Je peux comprendre que les jeunes générations pensent comme ceci. Après tout, la vie privée n'a déjà plus trop de sens pour eux aujourd'hui. On s'expose sur les réseaux, on publie des photos, des vidéos, on partage tout ce qu'on peut, bref, on vit dans l'instant. Alors après tout, si c'est pour attraper plus de terroristes, pourquoi pas être encore un peu plus surveillé ?

Le problème du "je n'ai rien à cacher" est qu'il ne faut pas oublier qu'il va de pair avec "aujourd'hui". Et peut-être qu'effectivement, aujourd'hui, je n'ai rien à cacher. Mais les données récoltées resteront des années, voire des décennies stockées sur des serveurs et utilisables dans de nouvelles statistiques. Et dans 10 ou 15 ans, lorsque nous aurons un Trump, une Le Pen, ou un Bolsonaro au pouvoir en France, et qu'il décidera d'utiliser toutes les données accumulées pendant des années pour faire des analyses statistiques poussées, pour ranger les citoyens dans les cases, et pour favoriser ceux qui ont le bon profil, que pourra-t-on faire ?

Aussi, afin d'éviter tous ces jugements à-priori qui favorisent l'intolérance dans notre société, et dans le but de conserver un minimum de tranquillité au quotidien, tout ceci devrait selon moi rester dans le cadre de la vie privée.

Le point de vue statistique

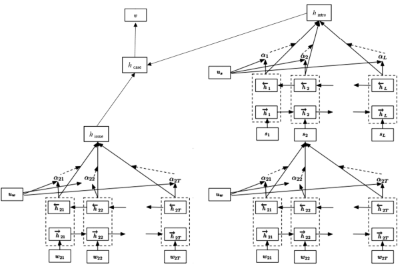

Mais l'argument qui me parait être le plus frappant pour rejeter la surveillance de masse est tout simplement statistique. Il est basé sur le théorème de Bayes, et plus particulièrement sur l'erreur fréquemment faite : l'oubli de la fréquence de base. Je vais essayer de présenter le raisonnement ici...

Données initiales

Avant tout, il faut définir 2 valeurs :

- D'après Wikipédia, la population française s'élève à environ 68 000 000 personnes.

- En se basant sur le nombre de personnes inscrites aujourd'hui au fichier des signalements pour la prévention de la radicalisation à caractère terroriste, on peut estimer qu'il y a en France environ 20 000 personnes affiliées au terrorisme. Ce chiffre n'est sans doute pas tout à fait exact, mais c'est l'ordre de grandeur qui m'intéresse ici.

En France, il y a donc environ 20 000 potentiels terroristes pour 68 000 000 d'habitants. La fréquence de base, c'est à dire ici la probabilité de trouver un terroriste parmi la population française, est donc de 68 000 000 / 20 000 = 1 / 3 400.

Écrivons un algorithme...

Imaginons que, pour prévenir la menace terroriste, nous décidions de surveiller l'activité de tous les citoyens, et donc de mettre en place une surveillance de masse automatisée basée sur des algorithmes complexes. Allez, disons des algorithmes de machine learning, c'est à la mode en ce moment. Imaginons que ces algorithmes soient suffisamment performants pour parvenir à identifier un terroriste dans la population avec une probabilité de 99%. Ça semble plutôt pas mal, non ?

Évaluons notre algorithme...

Nous allons maintenant utiliser cet algorithme pour identifier automatiquement les terroristes dans la population française. Sur les 20 000 potentiels terroristes, 99% x 20 000 soit 19 800 seront repérés. Même si notre algorithme n'est pas fiable qu'à 99%, c'est plutôt pas mal, car cela ne laisse que 200 personnes potentiellement dangereuses en liberté.

Si on stoppe la réflexion ici, on a un résultat tout à fait intéressant, et facile à mettre en avant afin d'argumenter pour une plus grande surveillance des individus. Le problème, c'est que si on s'arrête ici, on tombe précisément dans le piège de l'oubli de la fréquence de base.

En effet, il ne suffit pas de savoir combien de terroristes je vais pouvoir identifier avec mon superbe algorithme, mais il faut également calculer combien de faux positifs je vais générer, c'est-à-dire combien de personnes innocentes je vais identifier comme potentiellement terroristes.

Comme notre algorithme est fiable à 99%, il y a 1% d'erreurs. Et ce sont précisément ces 1% qui vont poser problème. En effet, pour 20 000 potentiels terroristes, nous avons 67 980 000 innocents. Et avec un tel test, qui est pourtant fiable à 99%, nous aurons 1% x 69 980 000 = 679 800 personnes innocentes qui seront détectées comme de potentiels terroristes.

Des résultats pas terribles...

Le résultat est donc le suivant :

Avec un algorithme fiable à 99% utilisé sur une population de 68 000 000 personnes, nous détectons 699 600 personnes potentiellement dangeureuses. Parmi elles, il y a 19 800 terroristes qui ont été correctement identifiés, mais aussi 679 800 innocents qui ont été mal identifiés. Cela signifie que sur les 699 600 potentiels terroristes identifiés, il y a en fait environ 2.8% de véritables terroristes. Pas si terrible que ça pour un algo fiable à 99%... Voire en fait... carrément nul.

Bon, on fait quoi alors ?

Essayons donc d'améliorer la précision de notre algorithme. Disons que nous arrivions à atteindre une précision de 99.9%. Nous détecterions alors 87 960 personnes, dont 17 980 terroristes, et 69 980 innocents. Cela nous amène à un taux de réussite d'environ 20%. Même si c'est beaucoup mieux, cela reste bien faible pour un algorithme fiable à 99,9%.

Et de toute façon, une précision de 99,9% est aujourd'hui totalement utopique pour un algorithme de ce genre. Les meilleurs algorithmes de deep learning sont aujourd'hui extrêment performants pour des tâches très précises, comme gagner au jeu de go ou analyser des photos pour détecter le cancer du sein par exemple. Mais obtenir une précision suffisante pour une tâche aussi complexe qu'identifier un terroriste dans la population, sachant que ce dernier va faire tout son possible pour passer inaperçu, est aujourd'hui totalement irréaliste.

Bref, il ne nous reste plus qu'à prendre notre bel algorithme qui nous a couté énormément de temps et d'argent et à se le mettre dans... hum pardon, je voulais bien sûr dire et à la mettre à la poubelle.

Conséquences potentielles

La surveillance de masse permet de récolter un maximum des données et de les analyser. Mais cela reste de l'analyse statistique. Et le problème avec les statistiques, c'est qu'elles sont valables uniquement à grande échelle. C'est très pratique pour envoyer de la publicité ciblée par exemple. Au lieu d'envoyer de la publicité en masse à un maximum d'individus, on peut par exemple évaluer en amont le profil des personnes le plus susceptible d'être intéressées par notre produit, et envoyer notre publicité à toutes les personnes correspondant à ce profil. Cela permet de réduire le coût de la pub, et de fortement majorer le retour sur investissement.

Mais la publicité, même si elle peut être intrusive et énervante parfois, n'a pas énormément de conséquences. En revanche, quand on touche à des domaines plus sérieux, cela peut devenir dangereux de tirer des conclusions trop rapides de données statistiques. Si pour des raisons statistiques mon nom se retrouvait sur je ne sais quelle liste noire, ma vie pourrait vite devenir compliquée...

Quelques exemples :

- Liste potentiel terroriste ⇒ difficultés pour voyager.

- Liste a des chances d'être à découvert ⇒ difficultés pour obtenir un crédit.

- Liste potentiel chauffard ⇒ difficultés pour trouver une assurance.

- Liste a des chances d'avoir un cancer ⇒ tarifs plus élevés d'assurance santé.

- Liste potentiellement violent ⇒ difficultés pour trouver un job.

- ...

Et malheureusement non, ce n'est pas qu'une utopie, car cela commence déjà à être mis en place en chine.

Pour conclure

Avec l'analyse des big datas, les statistiques n'ont jamais été aussi présentes dans notre monde que ces dernières années. Leur utilisation se fait maintenant dans tous les domaines, et c'est vrai que c'est grisant de voir tout ce qu'on peut tirer de ces milliards de données.

Mon avis, c'est que la surveillance des individus va continuer à s'amplifier, et qu'il sera de plus en plus difficile d'y échapper. Pour être honnête, je pense qu'il est déjà aujourd'hui bien difficile de conserver une vraie vie privée, à moins bien sûr de se couper de la technologie, mais ce n'est pas le but, car celle-ci nous apporte beaucoup au quotidien. Nous allons donc continuer à être toujours plus surveillés, analysés, étudiés, catégorisés.

Je vois deux points importants concernant cette surveillance qui s'intensifie :

Le premier point est que la majorité des gens ne connaît pas les conséquences potentielles de cette surveillance. Ils n'immaginent pas tout ce qui peut découler des milliards d'infos qui sont stockées sur eux. C'est un problème car les gens ne sont donc aujourd'hui pas en capacité de décider de leur avenir numérique.

Le second point est que les règles en statistiques sont en général assez mal comprises, car elles peuvent sembler totalement contre-intuitives. Et cela devient un vrai problème en particulier lorsque les personnes qui ont un pouvoir de décision et qui devraient pouvoir exploiter des données statistiques avec rigueur et éthique ne comprennent pas ce qu'il sont en train de faire.

Comme souvent, un peu plus d'éducation, de discussions, d'explications, d'instruction et de formation ferait le plus grand bien à tout le monde...